客户

一家领先的消费和企业计算OEM厂商,以其创新驱动的产品路线图而闻名,产品涵盖笔记本电脑、工作站和数据中心服务器。该公司正在迅速将先进的人工智能功能整合到其产品组合中,以提供差异化的用户体验。

问题陈述

作为其进军 生成式人工智能(GenAI) 战略的一部分,客户旨在探索一个统一的框架,以便在异构硬件加速器(包括计划用于其未来产品线的独立 NPU 和 GPU)上部署 GenAI 模型。

挑战在于,如何协调跨不同 SoC 和硬件后端的 AI 工作负载,而每个后端都需要各自的运行时堆栈、驱动程序配置和优化策略。客户需要一种可扩展的、与硬件无关的方法,该方法能够:

- 抽象底层加速器的多样性

- 支持多个 GenAI 用例(编码助手、基于 SDXL Turbo 的图像生成和图像标注)的早期部署

- 在保证开发人员效率和平台稳定性的同时,提供近乎实时的性能

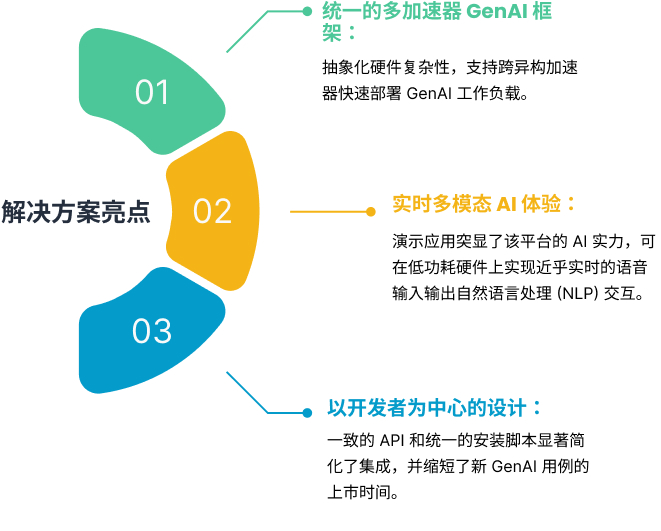

解决方案概述

MulticoreWare 与客户合作,设计了一个先进的统一 GenAI 赋能框架原型,该框架能够协调跨不同加速器的 AI 模型执行。该框架为客户评估其硬件组合的性能潜力奠定了基础,同时保持了一致的开发人员工作流程。原型的关键方面包括:

- 环境设置: 在 SoC 特定运行时上为 NPU 和 GPU 配置 AI 软件栈。统一的安装脚本简化了不同客户平台上的早期启动,减少了设置工作量。

- 模型集成: 集成了包括 Qwen2.5-Coder、SDXL Turbo、CodeLlama 和 Codestral 在内的前沿 GenAI 模型。启用了实时流和聊天模板功能,以支持对话式和多模态 AI 实验。

- API 开发: 提供了与OpenAI兼容的API,并支持基于IPC的运行时切换,允许在评估阶段动态选择加速器(GPU 或 NPU),以便更好地了解性能权衡。

- 性能优化: 实施了 KV 缓存处理、多设备并行和混合精度格式(W4A16、FP16)等优化措施,以加速推理并实现基准测试,而不会影响模型质量。

业务影响

该原型展示了客户将前沿的 GenAI 功能应用于节能平台的能力,突显了性能、可扩展性和能效之间的平衡。通过在笔记本电脑和服务器上实现 AI 部署的无缝实验,客户已进一步巩固了其迈向下一代计算体验的步伐。业务影响(重复,需要删除)

该原型展示了客户将前沿的 GenAI 功能应用于节能平台的能力,突显了性能、可扩展性和能效之间的平衡。通过在笔记本电脑和服务器上实现 AI 部署的无缝实验,客户已进一步巩固了其迈向下一代计算体验的步伐。

结论

通过交付一个统一的、与加速器无关的 GenAI 框架原型,MulticoreWare 帮助客户在异构硬件配置上评估和协调 AI 工作负载。此举加速了先进 GenAI 功能的早期应用,同时为客户产品组合中未来可用于生产环境的 AI 创新奠定了基础。

MulticoreWare 在 AI 框架、性能优化和多加速器支持方面的专业知识使这一先进原型成为可能。如需了解我们如何支持贵组织的 AI 项目,欢迎联系 info@multicorewareinc.com