作者Kavitha 拥有 20 多年的丰富工作经验,担任汽车、工业和医疗领域嵌入式系统开发的固件主管。她是 TUV SUD 认证的功能安全 L2 专业人士。她目前从事功能安全、网络安全、SOTIF 和 AI 系统安全方面的工作。

简介

人工智能是下一代自动驾驶汽车的驱动力,推动我们走向真正”自动驾驶”汽车的未来。功能安全至关重要,因为这些汽车必须模拟和替代人类的感知、直觉、智慧和决策能力。自动驾驶汽车需要依靠人工智能从现实世界场景的不同传感器中感知信息,才能安全行驶。

功能安全就是降低风险,以及当系统偏离预定义的安全目标时,车辆是否可以行驶回安全状态保证。这使得解决人工智能系统的可靠性和稳健性至关重要。

人工智能功能安全面临的挑战

人工智能模型固有的复杂性和不可预测性带来了一系列挑战,以确保功能安全风险已被明确处理。虽然传统的安全关键系统有完善的规则和确定性行作为指导,但人工智能模型可能仍存在不透明、自适应且容易发生不可预见的故障。以下概述了主要风险及其相应的缓解计划:

1. 缺乏可解释性

由于缺乏对决策过程的理解或限定透明度,人工智能模型(尤其是深度学习算法)被视为”黑匣子”。如果无法清晰地了解模型的决策过程,预测结果或确保功能安全就会变得更加困难。

可解释人工智能 (XAI) 作为人们理解人工智能模型行为的关键工具,并越来越受到关注。人们还认为,某些人工智能模型的可解释性优于其他模型。请阅读我们的BLOG – XAI 的应用和方法。

2. 数据质量、数量、依赖性和偏差

正如产品的质量取决于其开发过程中所用原材料的质量一样,深度学习系统的有效性取决于其训练数据的质量。此外,”越多越好”的原则也适用,因为更大、更多样化的数据集可以增强系统的稳健性。例如,使用不能全面代表真实世界条件的数据训练的自动驾驶汽车可能会在陌生场景或极端情况下表现异常,从而导致安全风险。真实世界场景可能因不同地区而异,因此在所有部署地区拥有足够的训练数据集至关重要。

生成式人工智能可用于生成合成数据,以全面训练模型。 阅读我们的BLOG – 机器人技术中的生成式人工智能集成。

3. 持续学习和适应

人工智能模型是在大型数据集上进行训练的,旨在学习和动态适应新的感知信息。然而,当暴露于与训练数据明显不同的环境或场景时,它们的行为可能会发生变化。虽然这种持续学习的能力是自动驾驶所必需的,但它引发了对功能安全的担忧。例如,自动驾驶汽车可能会根据新数据调整其决策,但如果没有仔细监控,它可能会发展出在最初部署时既不存在也未经测试的不安全行为。

可以添加安全监视器,这本质上是一个非人工智能模块,用于在出现误读时覆盖人工智能模型的决策。这种方法正在研究中,可能需要付出巨大努力才能部署。

4. 测试和验证

传统的安全关键系统可以通过模拟、故障注入和形式验证进行严格的功能安全测试。然而,测试深度学习模型面临着巨大的挑战。通常很难详尽地测试所有可能的情况,因为模型可能会遇到极端情况或从未见过的情况。人工智能的动态特性也使得在其整个生命周期内确保安全性变得具有挑战性,因为系统会不断学习和发展。

然而,旨在处理人工智能、机器学习和深度学习模型的新兴测试工具将在不久的将来解决这个问题。

5. 安全关键系统中的资源限制 AI 模型可能需要大量计算,需要大量处理能力、内存和计算资源。在关键的安全应用中,硬件本身可能会受到限制,这可能会限制部署稳健 AI 模型的能力。确保这些模型在这种限制下保持安全可靠可能是一项重大挑战,尤其是在处理实时处理要求时。此外,依赖传感器输入(例如 LIDAR、RADAR、ToF、摄像头)的 AI 系统必须能够抵御传感器漂移、故障或不准确。

计算环境越来越能够适应深度学习模型的部署。但是,仍需解决与功耗、尺寸、成本和其他限制相关的挑战。

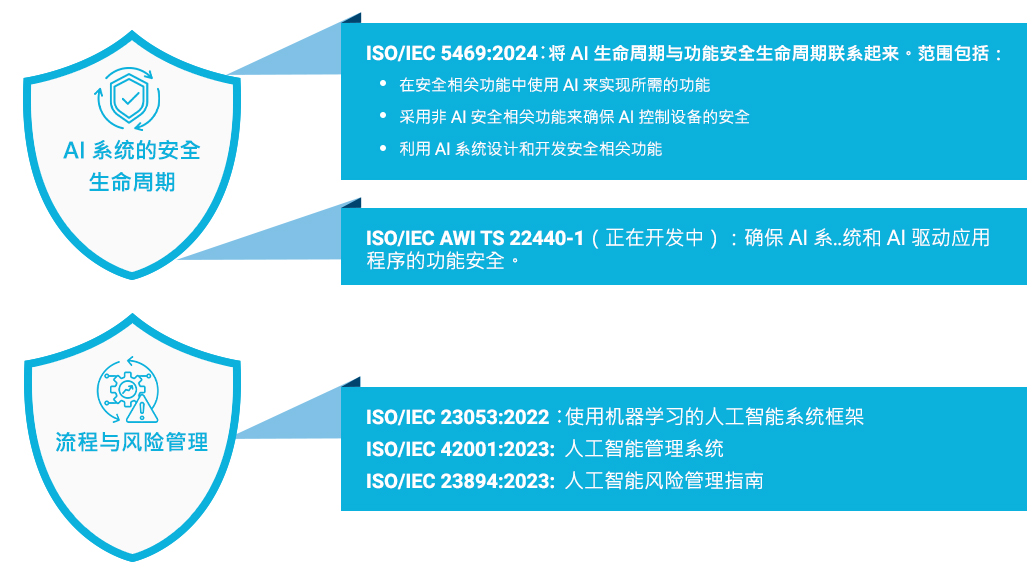

6. 不断发展的行业标准和监管指南 功能安全标准、汽车系统的 ISO 26262:2018 和工业应用的 IEC 61508 为确保传统系统的安全提供了指导。然而,对于人工智能系统,尤其是那些使用机器学习的系统,几乎没有完善的功能安全标准。监管框架和不断发展的标准之间的这种差距使得行业难以采用最佳实践并确保人工智能驱动的产品和服务的安全。

虽然标准正在制定中,但它们可能需要几年时间才能完全融入深度学习模型的开发和训练过程。

ISO/PAS 8800(预计不久后发布):

- 根据 ISO 26262、ISO 21448、ISO/TR4804 和 ISO/IEC TR 5469 指南,定义可能导致 AI 模型性能下降或故障的安全相关属性和风险因素。

- 安全要求、数据质量和完整性、故障缓解

- 支持基于 AI 的开发、验证和确认的工具

- 实现 AI 系统目标的安全保证论据和证据

ISO/DTS 5083 道路车辆 – 自动驾驶系统安全 – 设计验证和确认(草案处于批准阶段) – 将取代 ISO/TR 4804:2020

7. 道德和责任问题

在功能安全领域,道德考量起着重要作用。如果人工智能系统发生故障并对人类生命造成风险或伤害,确定责任可能具有挑战性。人工智能模型通常由大量数据科学家和工程师设计,因此很难确定故障的确切原因。

为人工智能系统建立明确的责任和道德准则对于解决功能安全问题至关重要。安全风险也随之而来,因为黑客可能会控制系统并导致潜在危险。如果发生不可避免的事故,决定是否优先考虑车辆乘员或车辆周围人员的安全是一个复杂且有争议的问题。

MulticoreWare 的独特定位

通过我们的专业工程师确保安全合规。我们处理功能安全要求、安全强化库和应用程序源代码。

高级 AI/ML 算法 + 边缘优化 + 功能安全服务

- Automotive SPICE: 差距分析、流程改进和预评估。

- Functional Safety (FuSa): 合规软件实施、测试、V&V、FuSa 套件、差距分析以及重新设计建议和开发

- 具有 AI 模型的系统安全性: 安全分析、ML/DL 模型的 V&V 以及开发用于故障安全功能的安全笼。

结论

保证 AI 模型的功能安全是一项多方面的挑战,需要采取全面的方法,包括透明度、严格的测试、有效的数据质量管理和制定新的安全标准。我们在 ISO 26262 标准方面拥有深入的专业知识,确保设计和开发安全可靠的电气和电子系统。如需了解更多信息,请写信给我们: info@multicorewareinc.com