作者

Selventhiran Rengaraj 是MulticoreWare移动与交通业务部门的副技术项目经理。他在开发地面和水下机器人的机器人技术栈方面有丰富的实践经验,并致力于在领先的汽车半导体平台上进行尖端人工智能和ADAS感知技术栈的优化工作。

介绍

仅仅几十年前,机器能够思考的想法还属于科幻领域。但是,如今的机器已经不再仅仅是工具,它们在我们的思考、创造和决策中发挥着作用。人工智能(AI)已经改变了我们生活的许多方面。从Siri和Alexa等虚拟助手到先进的机器学习算法预测疾病爆发,AI在众多应用中显现出来。生成式AI和自然语言处理的进步推动了像ChatGPT这样的技术,使得AI对话感觉非常接近人类。

可解释性AI(Explainable AI)和负责任的AI(Responsible AI)之间有什么区别?

设想这样的情景:一辆自动驾驶汽车面临一个棘手的情况,比如一个意外闯入道路的孩子。

可解释性AI(XAI)– 帮助AI科学家和用户理解汽车的决策过程,通过分析AI使用的数据(摄像头录像和传感器读数),了解自动驾驶汽车的“大脑”——AI算法为什么选择了特定的行动(比如刹车或转向)。 类似于黑匣子分析,这对于未来的改进非常有益,但并不能阻止即时事件的发生。

负责任的AI- 负责任的AI在自动驾驶出行中,关注安全和可靠性。它包括解决导航、避免碰撞、行人安全和遵守交通法规等挑战。负责任的AI致力于通过优先考虑安全关键组件和伦理框架,推进可靠、值得信赖和安全的自动驾驶出行解决方案。 <>

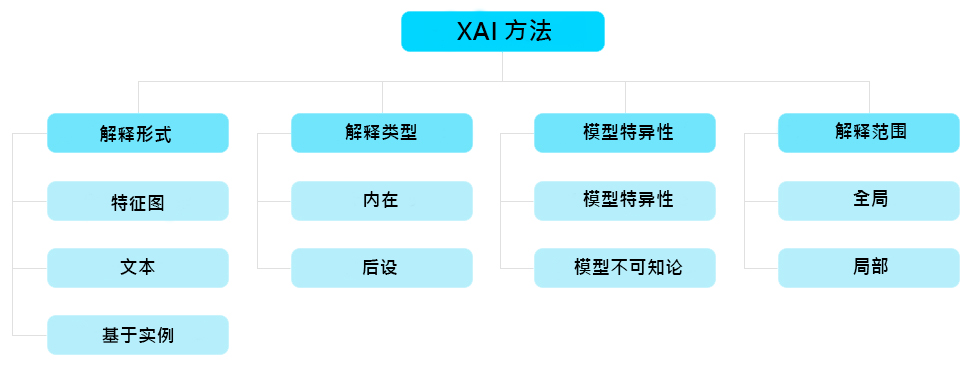

计算机视觉中的可解释性AI(XAI)方法

理解AI决策对于安全AI系统至关重要。研究界优先考虑XAI方法的进展,以满足这一需求。例如,在计算机视觉中,XAI揭示了哪些图像元素影响模型的预测(分类、检测等)。这对于复杂环境下的AI模型至关重要(例如印度的道路常常不可预测且混乱)。XAI识别模型中的潜在弱点和偏见,减少用户对意外行为的焦虑。

展示预训练模型在检测和分割任务中结果的解释(使用在印度道路上拍摄的输入图像)

2D目标检测的可解释性

2D语义分割的可解释性

Original Image Source: India Driving Dataset (https://idd.insaan.iiit.ac.in/dataset/details/)

可解释性是否等同于模型输出的可视化(模型的定性输出)?

不!可视化帮助我们以清晰易懂的格式查看结果,但“可解释性”涉及理解影响模型输出的主要因素。它揭示了人工智能决策过程背后的原理。

可解释性AI的类型

-

内在性(基于模型的可解释性):通过调整结构组件,模型本身是可解释的(例如,短决策树或稀疏线性模型)。

-

后续技术通过构建附加模型来分析现有训练模型,并提供有关其决策过程的见解。

-

模型特异性方法仅适用于特定应用范围(例如,DeepLIFT、Grad-CAM、Integrated Gradients)。

-

模型无关方法可应用于任何机器学习模型,无论其结构或类型(例如,LIME和SHAP)。

-

局部解释 将模型视为黑匣子,关注对决策有贡献的局部变量。通常,局部解释关注单个输入数据集及其相关特征变量。

-

全局解释关注了解整个模型的工作方式。它分析不同数据片段在模型内部如何相互作用,从而影响模型的最终输出。

挑战与局限性

尽管可解释性AI的概念似乎有助于建立对AI系统的信任并确保其责任,但其开发面临着许多挑战。

-

AI的复杂性: 如今,AI模型通过处理大量数据来改进特定任务,无论是图像识别还是自主导航。然而,将这些复杂的数学模型转化为人类易于理解的简单解释是困难的。

-

可解释性和性能之间的权衡: 大多数AI模型优先考虑效率,仅关注提供结果,而不重视解释其操作的重要性。

-

保护隐私: 理解AI决策通常需要分析敏感数据,这会在没有适当保护措施的情况下危及隐私和安全。清晰的指南和协议对于在可解释性AI中安全处理数据至关重要。

结论——安全且可解释的人工智能的未来之路

结论——安全和可解释性AI的未来之路 随着AI的不断发展,优先考虑安全性和可解释性至关重要。研究人员和开发人员之间的合作是利用AI产生积极影响的关键,同时确保它在世界的复杂性中具备安全性、透明性和可靠性。在接下来的博客中,我们将讨论可解释性AI的最新趋势以及SOTA基于Transformer的AI模型在解释性方面的关键作用。

要了解有关我们如何负责地构建AI解决方案的更多信息,请发送电子邮件至 info@multicorewareinc.com