客户

客户是一家基于RISC-V的AI加速器公司。

挑战

客户的加速器硬件只能通过其 NN 软件生态系统支持最低限度的机型。该项目的目标是扩展对其他各种模型的支持。

MulticoreWare 使用自定义 API 为其架构中的各种 CNN 和 NLP 模型运行端到端推理流水线。我们必须为其架构中的各种 CNN 和 NLP 模型编写模型演示,并在客户自己的 AI/ML 编译器堆栈中将不支持的 TVM 操作与支持的操作进行分解。

解决方案

凭借我们在过去和现在在各种客户硬件上对端到端模型推理管道的专业知识,我们的解决方案架构师团队能够为客户硬件的不同架构添加对ShuffleNet、YoloV5、HardNet、DDRNet、DLA及其他各种CNN、NLP和基于Transformer的模型及其变体的支持。在支持上述模型的同时,我们还处理和支持不同的故障和错误。

我们使用 PyTorch 和 ONNX 参考代码以及 PCC 指标测试了模型推理管道的正确性。在快速开发应用程序接口和功能的过程中,我们也适应了应用程序接口,并通过理解内存布局和配置,以最少的文档提升了一些模型。

尽管面临文档有限和快速发展的仓库开发的挑战,我们的团队成功适应了新API,确保满足了客户的需求。这一成就突显了我们快速学习和应用新技术的能力,克服障碍,提供高质量的结果。

解决方案亮点

- 我们的团队开发了端到端模型推理管道,并使用其API将20多个基于CNN和NLP的模型集成到其微架构中。

- 我们进行了单元测试,并报告了所有模型中不受支持的操作变体和问题。

商业影响

MulticoreWare通过提供全面的AI生态系统,增强了客户的市场竞争力,吸引了更广泛的客户群。该项目还通过增加对其AI硬件和API的采用,创造了更多的收入机会,从而推动了客户的业务增长。

结论

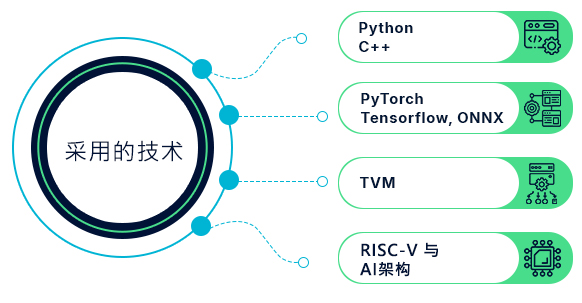

总之,MulticoreWare展示了对各种模型的支持能力以及在AI加速器、优化、RISC-V和AI架构、TVM、PyTorch、Tensorflow、ONNX等方面的专业知识。了解我们如何帮助您实现创新成果。请通过info@multicorewareinc.com 联系我们的团队。